Hirnforschung mit Rechnerpower

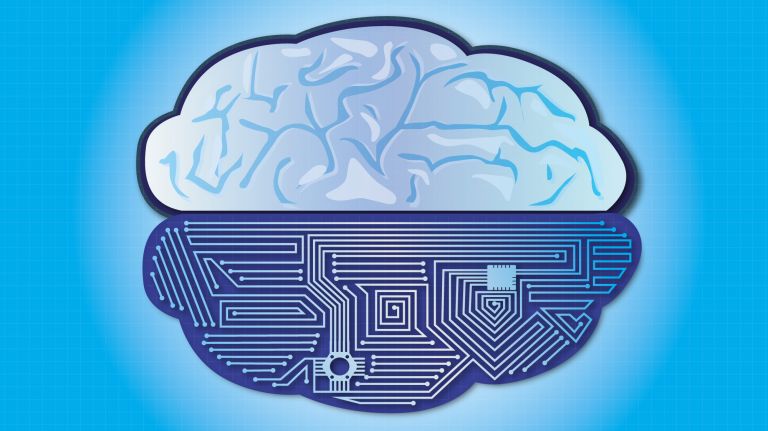

An der Schnittstelle von Neurobiologie und Informatik erkundet die Neuroinformatik, wie Lebewesen Informationen verarbeiten – und sucht nach Wegen, um die zugrunde liegenden biologischen Prinzipien auf Computer zu übertragen.c

Scientific support: Prof. Dr. Jochen Triesch

Published: 30.05.2019

Difficulty: easy

- Riesige Massen an Daten werden regelmäßig erhoben und können nicht mehr komplett von Hand analysiert werden. Um hier weiter zu kommen, muss man große Rechenpower klug einsetzen.

- Das Bernstein-Netzwerk hat sich der Erforschung, Entwicklung und Anwendung verschiedenster Methoden verschrieben. Wissenschaftler in sechs Bernstein-Zentren, vier Foki und mehr als 200 Arbeitsgruppen arbeiten daran.

- Neuronale Netzwerke helfen, Auswertungen zu beschleunigen und zu verbessern. Maschinelles Lernen wird heute schon zur Diagnoseunterstützung in der medizinischen Forschung eingesetzt.

- Da das Feld noch relativ jung ist, sind die weiteren Entwicklungen spannend und schwer vorhersagbar. Denkbar ist die Entwicklung einer künstlichen Intelligenz, mit deren Hilfe medizinische Diagnosen schnell und zweifelsfrei getroffen werden können.

Honigbienen, die von nektarreichen Blüten in ihren Stock zurückkehren, führen eine kleine Tanzeinlage auf, um ihren Kolleginnen mitzuteilen, wo sich die lohnende Futterquelle befindet. Doch wie entnehmen die wartenden Immen die Information aus dem Bienentanz – und das sogar im dunklen Bienenhaus? Wenn Ratten in die Pubertät kommen, durchläuft ihr Gehirn einen massiven Umbauprozess. So wachsen etwa die Bereiche, die die Genitalien der Nager repräsentieren. Wie aber hängt das mit der Berührung der selbigen zusammen? Ungezählte Sinnesreize strömen fortwährend auf unser Denkorgan ein. Doch wie resultiert daraus blitzschnell eine sinnvolle und präzise Reaktion, die ein normales Leben und ein Überleben in Gefahrensituationen gewährleistet?

So unterschiedlich diese Forschungsfragen auf den ersten Blick sind, ist ihnen doch eines gemeinsam: Sie sind nicht nur spannend, sondern hochgradig komplex. So komplex, dass sie sich mit einzelnen neurowissenschaftlichen Laborexperimenten kaum erfassen lassen.

An dieser Stelle kommt das Forschungsfeld der Computational Neuroscience ins Spiel – und das Bernstein-Netzwerk, das sich in Deutschland federführend dieser Disziplin verschrieben hat. Benannt nach dem Physiologen und Biophysiker Julius Bernstein (1839-1917), der im Jahr 1902 eine erste biophysikalische Erklärung dafür lieferte, wie Nervenzellen Informationen durch elektrische Ströme weiterleiten und verarbeiten, wurde das Netzwerk 2004 gegründet und vom Bundesministerium für Bildung und Forschung (BMBF) gefördert. Heute umfasst es sechs Zentren, vier Bernstein Foki, die sich der anwendungsbezogenen Forschung und Projekten zur künstlichen Intelligenz widmen, sowie insgesamt mehr als 200 Arbeitsgruppen an verschiedenen Standorten in Deutschland, aber auch jenseits der Landesgrenzen.

Beim Begriff Computational Neuroscience mögen viele spontan an künstliche Intelligenz denken, wie man sie aus Filmen wie „Matrix“ oder „A.I. – Artificial Intelligence“ kennt. Doch tatsächlich geht es hier um etwas anderes. Die theoretische Neurowissenschaft oder auch computergestützte Neurowissenschaft, wie sich das Fachgebiet im Deutschen bezeichnen lässt, verbindet neurowissenschaftliche Ansätze aus dem Labor mit den Methoden der Informatik und der Mathematik. Wissenschaftler dieser Disziplin entwickeln Computersimulationen und mathematische Modelle, um so das komplexe Zusammenspiel in Gehirn erfassen zu können.

Bienentanz, Rattenpubertät und heiße Herdplatten

Das große Ziel ist, zu verstehen, wie das Gehirn Informationen verarbeitet. Wie eine einzelne Nervenzelle funktioniert, weiß man schon recht gut. Doch damit eine Biene den Tanz der anderen versteht, die Rattenpubertät voranschreitet und das Gehirn einströmende Reize derart verarbeitet, dass wir beispielsweise die Hand von der heißen Herdplatte zurückziehen, braucht es ein komplexes räumliches und zeitliches Zusammenspiel einer Vielzahl von Neuronen und den Nervenzellnetzwerken, in die sie eingebunden sind. Um das zu entschlüsseln entwickeln Forscher aus den Ergebnissen von Laborexperimenten mathematische Modelle, mit denen sich neuronale Funktionen simulieren und Vorhersagen über das Zusammenspiel im Denkorgan treffen lassen. Die daraus resultierenden Hypothesen überprüfen Laborforscher anschließend in weiteren Experimenten, die im nächsten Schritt zu einem verbesserten Modell führen. Dieses Wechselspiel bringt die Forschenden dem Verständnis der Hirnfunktionen so Stück für Stück näher.

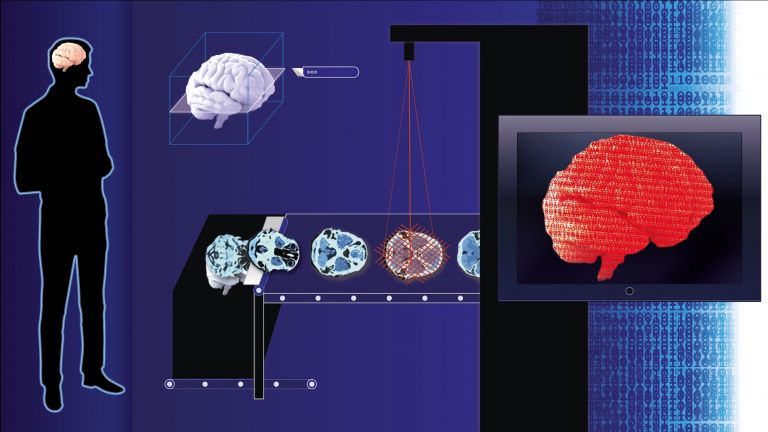

Eine der Konstanten, die sich durch alle Bereiche der Computational Neuroscience zieht, ist die immense Menge an Daten, die es zu analysieren gilt. Aufgrund der großen Datenmengen, die heutzutage erhoben werden können, können Verarbeitungsprozesse im Gehirn fast nur noch mithilfe der Computational Neuroscience erforscht und erklärt werden“, sagt Matthias Bethge Koordinator des Tübinger Bernstein-Zentrums.

Bereits wenn man die Daten aus einem Elektro-Enzephalogramm interpretieren will, gilt es neben der zeitlichen und räumlichen Dimension, also wann und in welchem Bereich das Gehirn arbeitet, auch noch Informationen über Oszillation und Frequenzen zu interpretieren. Diese geben Aufschluss über die beteiligten neuronalen Netzwerke und den Bewusstseinszustand.

Wie wichtig es ist, alle Komponenten zu berücksichtigen, zeigt ein simples Alltagsbeispiel: Blinkt im Auto die Warnlampe auf, die einen Motorschaden anzeigt, oder macht der Motor komische Geräusche, so ist klar, dass die Karre in die Werkstatt muss. Doch damit der Mechaniker dann den Fehler findet und das Auto reparieren kann, muss er viele weitere Informationen berücksichtigen. Allein das blinkende Lämpchen und die Motorgeräusche reichen dafür nicht aus.

Recommended articles

Moleküle, Zellen und Organe im Computer

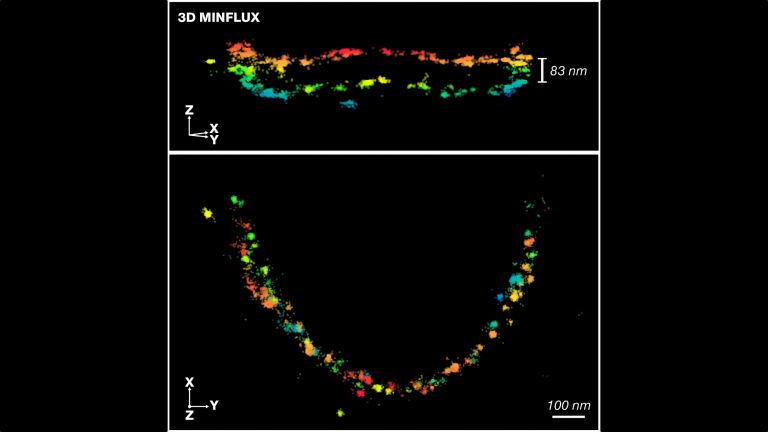

Um zu verstehen, was im Gehirn passiert, liegt es nahe, sich Stufe für Stufe von der kleinsten Einheit im System bis zu komplexen Netzwerken und irgendwann einmal sogar zum ganzen Gehirn vorzuarbeiten. D ie unterste Ebene stellen einzelne Atome dar, die sich wiederum zu Molekülen zusammensetzen. Dies können beispielsweise Fettsäuren in der Zellmembran sein, ebenso wie Moleküle an den Synapsen, den Schaltstellen zwischen den Nervenzellen. Anhand bekannter chemisch-physikalischer Wechselwirkungen zwischen Protein- oder Fettsäurebestandteilen lässt sich in aufwändigen Kalkulationen veranschaulichen, wie die verschiedenen Komponenten miteinander interagieren. Das ist zum Beispiel wichtig, um die Fusion von synaptischen Vesikeln mit der Zellmembran zu verstehen – ein Schlüsselereignis für den Austausch von Botenstoffen zwischen den Nervenzellen. Noch umfasst das Zeitfenster für die Simulation solcher Prozesse nur wenige Nano- bis Mikrosekunden. Das reicht gerade mal, um einen Blick auf einen kurzen Ausschnitt des Geschehens zu erhaschen. Bis sich vollständig erfassen lässt, wie ein Vesikel mit der Zellmembran verschmilzt, ist es noch ein weiter Weg – ganz zu schweigen von der Simulation von Denkprozessen. Doch immer stärkere Computer werden das Forschungsfeld in Zukunft diesem Ziel langsam näherbringen.

Je weiter Wissenschaftler auf der Leiter der funktionellen Ebenen des Gehirns emporklettern, umso komplexer wird das Geschehen und umso unschärfer werden die Details, die sich mit den verfügbaren Methoden erfassen und simulieren lassen. Bereits bei einem größeren Ausschnitt eines Neurons gilt es daher, in etwas gröberen Rastern zu denken. So lässt sich beispielsweise berechnen, wie sich größere Mengen von Calzium-Ionen im Inneren einer Synapse bewegen und dazu beitragen, dass diese Botenstoffe ausschüttet. Solche Simulationen umfassen deutlich längere Zeitspannen als die auf der rein atomaren und molekularen Ebene. Und sie erlauben bereits, gesunde und kranke Systeme zu vergleichen, um Einblicke in gestörte Funktionen zu gewinnen.

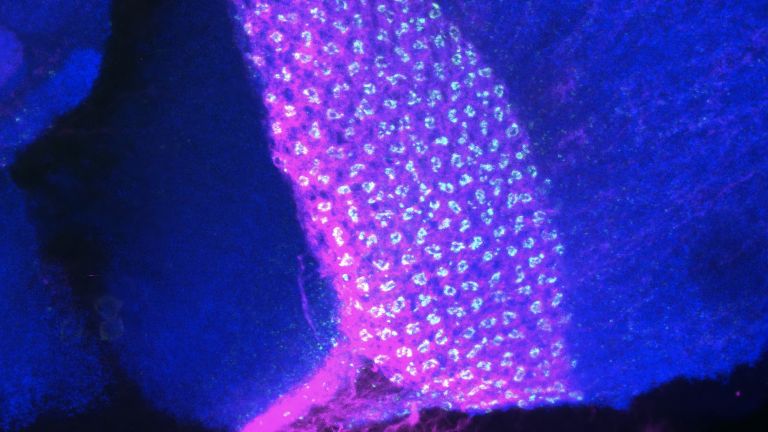

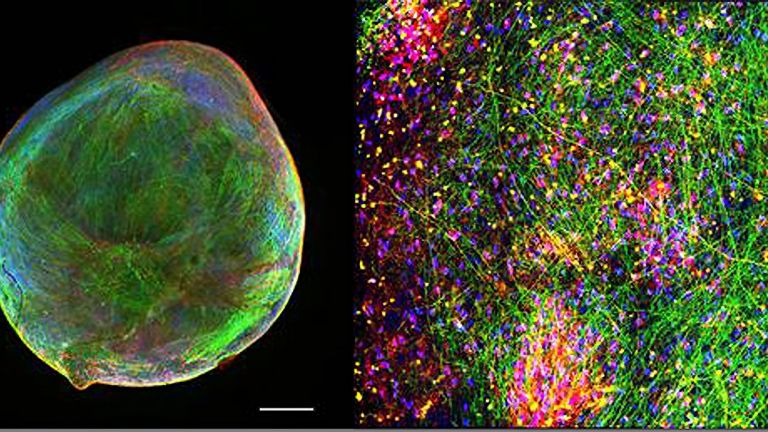

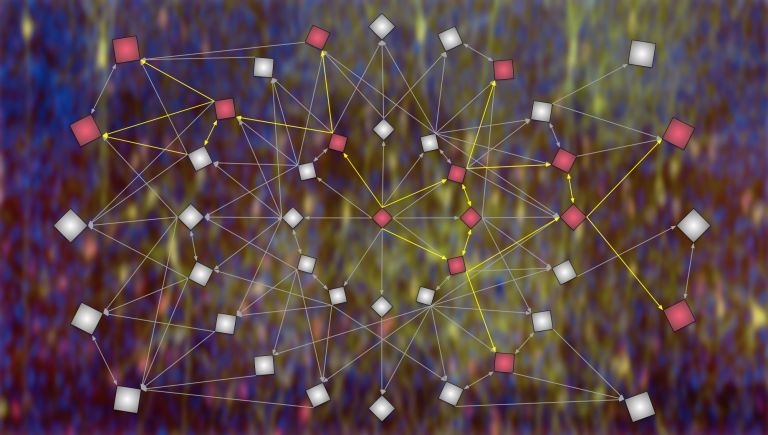

Um nachzuvollziehen, wie schließlich ein Nervensignal entsteht und wie dieses zum richtigen Teil des Gehirns gelangt, simulieren Wissenschaftler Netzwerke aus vielen Zellen. Dafür braucht es Informationen darüber, wie diese Netzwerke überhaupt aussehen. Dieser Fragestellung hat sich etwa das Human Connectome Project verschrieben. Die Idee ist, die Verbindungen im Gehirn zu erfassen, und zu verstehen, wie sie zusammenwirken. Per Hand einzelne Nervenzellen aus dem Gehirn zu isolieren und wie bei einem Stromkabel Ursprung oder Ziel nachzuverfolgen, ist kaum möglich. Vielmehr entstehen hier hochauflösende Bildgebungsverfahren und Informatik-Werkzeuge, die irgendwann einmal alle Datenautobahnen im Gehirn darstellen. Am Ende soll dies dazu dienen, ein ganzes Gehirn zu simulieren, so wie es das kontrovers diskutierte „Human Brain Project“ [6] bereits in kleinen Teilen versucht. Dieses Projekt wurde von der EU mit riesigen Fördermitteln bedacht, die hoffentlich in Zukunft große Fortschritte bringen werden. Momentan befasst es sich unter anderem damit, Neuronen-Populationen und einzelne Netzwerke darzustellen. So können Wissenschaftler bereits jetzt mithilfe von Computern medizinischen Fragestellungen nachgehen und dabei die Anzahl von Tierversuchen reduzieren.

Lernfähige Maschinen sind bereits Realität

Mit der Simulation ganzer Neuronen-Netzwerke lässt sich aber noch etwas anderes bewerkstelligen. Und hier verzahnt sich die Computational Neuroscience mit einem anderen, nicht minder interessanten Feld: der künstlichen Intelligenz. Ein Computer lässt sich derart programmieren, dass er in der Lage ist, sich aus großen Datensätzen selbst Sachen beizubringen. Die Rede ist von maschinellem Lernen. Dies wird je nach Komplexität auch „deep learning“ genannt, einem laut Michael Brecht, dem Koordinator des BCCN Berlin, immens wichtigen Methodenfeld. „I n den letzten Jahren entstand ein riesiges Interesse an den Gehirninspirierten Rechenarchitekturen in der künstlichen Intelligenz.“ Auch sein Kollege vom Tübinger BCCN, Matthias Bethge, benennt das maschinelle Lernen als eine der wichtigsten Methoden der Neuroinformatik.

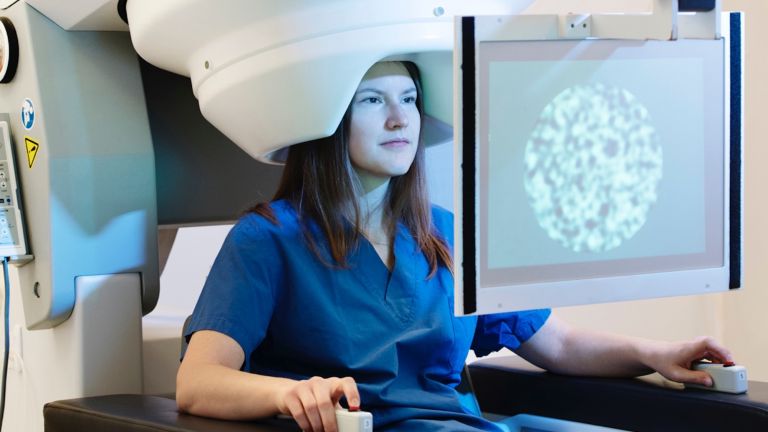

Wissenschaftler füttern dabei große Datensätze in einen Computer, von denen man ganz genau weiß, was darauf abgebildet ist – etwa zehntausende Aufnahmen von Hautkrebs. Dieser versucht dann anhand dieses Trainings und mithilfe künstlicher neuronaler Ebenen, neue, bislang unbekannte Bilder einzuordnen und erkennen, was sich darauf befindet.

Dieses Vorgehen lässt sich heute schon erfolgreich in medizinisch relevanten Fällen umsetzen. So hat ein Team aus Heidelberg ein selbstlernendes Computerprogramm entwickelt, das Hautkrebs erkennt – und zwar besser als Ärzte es vermögen. Ein weiteres Beispiel: Unter der Schirmherrschaft von Google lernte ein solches Programm in einem anderen Fall durch „deep learning“ anhand von Abbildern der Netzhaut aus dem Auge Geschlecht, Blutdruck und Alter der Person zu erkennen. Anhand welcher Eigenschaften der Computer letztlich seine Entscheidung trifft, vermag derzeit Niemand anschaulich zu erklären. Denn zwar kennt man alle Informationen, die das System erhalten hat, doch wie es daraus seine Schlussfolgerung zieht, ist zu komplex. Daran wird ersichtlich, dass diese Methode viele menschliche Kapazitäten übersteigt. Es ist allerdings auch problematisch, wenn der Mensch nicht mehr versteht, wie ein neuronales Netzwerk überhaupt zu einem bestimmten Schluss gekommen ist.

Es herrscht Aufbruchstimmung, und selbst Experten können die Möglichkeiten der Neuroinformatik kaum überschauen. „Die langfristigen Implikationen der Hirnforschung und der Computational Neuroscience sind tatsächlich nicht voraussagbar, weil das Feld in so großer Bewegung ist“, bekräftigt BCCN-Forscher Michael Brecht.